Introduzione: una svolta per l’Italia digitale

L’intelligenza artificiale (IA) è ormai parte della nostra vita quotidiana: la troviamo nei motori di ricerca, nelle chat intelligenti, nelle app di traduzione, nelle automobili e persino nei sistemi sanitari.

Ma fino a poco tempo fa, mancavano regole chiare su come questa tecnologia dovesse essere usata in modo sicuro, etico e trasparente.

Per questo motivo, l’Italia è diventata nel 2025 il primo Paese dell’Unione Europea ad approvare una legge nazionale sull’intelligenza artificiale, anticipando molti aspetti dell’AI Act europeo.

L’obiettivo? Garantire che l’IA migliori la vita delle persone, senza metterne a rischio diritti, sicurezza o libertà.

Cos’è la legge italiana sull’IA

L’entrata in vigore della Legge 23 settembre 2025, n. 132 («Disposizioni e deleghe al Governo in materia di intelligenza artificiale») nasce con un duplice intento: promuovere l’innovazione e proteggere i cittadini.

In altre parole, non vuole fermare lo sviluppo dell’IA, ma assicurare che venga usata in modo responsabile.

Ecco i principi fondamentali su cui si basa:

- Trasparenza: chi utilizza un sistema di IA deve sapere che sta interagendo con una macchina e non con una persona.

- Controllo umano: le decisioni importanti (ad esempio in campo medico, giudiziario o lavorativo) devono sempre poter essere comprese e, se necessario, corrette da un essere umano.

- Responsabilità: chi progetta, distribuisce o utilizza un sistema di IA deve rispettare regole precise e risponde delle conseguenze dei propri atti.

- Etica e tutela dei diritti: la tecnologia non può violare la dignità, la privacy o la libertà delle persone.

I principali ambiti di applicazione

La legge si applica a tutti i sistemi di intelligenza artificiale utilizzati in Italia, ma dedica una particolare attenzione ad alcuni settori considerati “sensibili”:

- 🏥 Sanità: obbligo di trasparenza per gli algoritmi che supportano diagnosi o trattamenti. Il medico resta sempre il decisore finale.

- 👩🏫 Istruzione: vietato l’uso di IA per valutare automaticamente studenti o insegnanti senza supervisione umana.

- 💼 Lavoro: i datori di lavoro devono informare i dipendenti se usano sistemi di IA per la selezione o la valutazione delle performance.

- 🏛️ Pubblica amministrazione: l’uso dell’IA deve rispettare i principi di imparzialità, trasparenza e tutela dei dati personali.

- 🌐 Servizi digitali e social media: maggiore controllo sugli algoritmi di raccomandazione e sui sistemi che generano contenuti o deepfake.

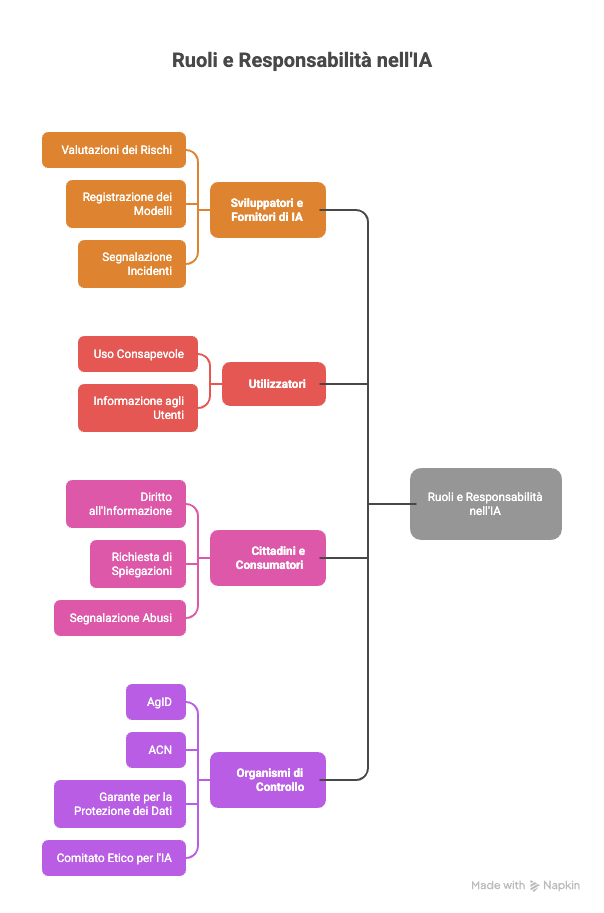

Diritti e doveri: chi fa cosa

La legge individua diversi soggetti coinvolti nel ciclo di vita dell’IA.

Ecco i principali ruoli e le loro responsabilità:

👩💻 Sviluppatori e fornitori di IA

- Devono garantire che i sistemi siano sicuri, affidabili e spiegabili.

- Hanno l’obbligo di effettuare valutazioni dei rischi e di registrare i modelli di IA ad alto rischio in un registro nazionale.

- Sono tenuti a segnalare eventuali incidenti o malfunzionamenti che possano danneggiare gli utenti.

🧑💼 Utilizzatori (aziende, PA, professionisti)

- Devono usare l’IA in modo consapevole e conforme alla legge.

- Hanno l’obbligo di informare gli utenti quando impiegano sistemi automatizzati che possono incidere sui loro diritti (es. decisioni contrattuali o selezioni).

👨👩👧 Cittadini e consumatori

- Hanno diritto a essere informati quando interagiscono con un sistema di IA.

- Possono chiedere spiegazioni su come un algoritmo ha preso una decisione che li riguarda.

- Possono opporre o segnalare l’uso scorretto o dannoso dell’IA alle autorità competenti.

Gli organismi di controllo

La legge istituisce un Sistema nazionale di supervisione dell’intelligenza artificiale, composto da:

- Agenzia per l’Italia Digitale (AgID): coordina la strategia nazionale e i registri dei sistemi IA.

- Agenzia Nazionale per la Cybersecurity (ACN): vigila sulla sicurezza informatica dei sistemi.

- Garante per la protezione dei dati personali: controlla la conformità con il GDPR.

- Comitato Etico per l’IA: organismo consultivo formato da giuristi, esperti di etica e tecnologi, che fornisce linee guida sull’uso corretto della tecnologia.

Le sanzioni e le tutele

Per rendere la legge efficace, sono previste sanzioni severe in caso di violazioni:

- multe fino a 20 milioni di euro o al 4% del fatturato per le aziende che usano IA senza rispettare i requisiti di sicurezza o trasparenza;

- reclusione da 1 a 5 anni per chi diffonde o utilizza deepfake lesivi della reputazione o sistemi IA per fini fraudolenti;

- sospensione o divieto d’uso dei sistemi che mettono a rischio la sicurezza o i diritti fondamentali delle persone.

In parallelo, lo Stato ha creato un fondo da 1 miliardo di euro per sostenere le imprese italiane che vogliono sviluppare soluzioni di IA “etica”, inclusiva e sicura.

Esempi pratici: come la legge ci riguarda davvero

- Nel lavoro: se un’azienda usa un software di selezione automatica, il candidato deve essere informato e può chiedere che la decisione sia rivista da una persona.

- Nei social media: se un video o un’immagine è generato artificialmente, deve riportare un’indicazione chiara come “contenuto creato con IA”.

- Nella sanità: un paziente ha diritto di sapere se una diagnosi o una proposta terapeutica è stata elaborata da un sistema automatizzato.

Questi esempi mostrano come la legge non parli solo di tecnologia, ma di fiducia e responsabilità condivisa.

Le sfide future

La legge italiana rappresenta un passo avanti importante, ma il percorso è appena iniziato.

Restano aperte molte sfide:

- Come garantire la verificabilità dei sistemi di IA più complessi e opachi?

- Come assicurare formazione e consapevolezza tra cittadini e imprese?

- Come bilanciare innovazione e protezione, evitando di frenare la competitività italiana ed europea?

Il vero banco di prova sarà la collaborazione tra giuristi, tecnologi, imprese e cittadini, perché solo un approccio condiviso può rendere l’IA uno strumento al servizio dell’uomo.

Conclusione: una legge per un futuro umano

La legge italiana sull’intelligenza artificiale non è solo un testo normativo: è un patto di fiducia tra persone e tecnologia.

Vuole dirci che l’innovazione è una grande opportunità, ma deve avere un cuore umano, una direzione etica e una responsabilità chiara.

Come avvocato, credo che il compito di tutti — professionisti, imprese, cittadini — sia quello di conoscere le regole, rispettarle e contribuire a costruire un futuro digitale giusto, sicuro e trasparente.

Nel prossimo articolo analizzeremo insieme le implicazioni della nuova normativa nell'ambito della mediazione civile commerciale e della Giustizia Consensuale.

Per scaricare il testo vai sul Sito della Gazzetta Ufficiale (www.gazzettaufficiale.it) scaricando l’edizione n. 223 del 25 settembre 2025 (serie generale) nella quale è pubblicata la legge.

Commenti ()